昨晚 Open AI 居然发布的是开源模型就是前几天泄露的 gpt-oss-120b 和 gpt-oss-20b

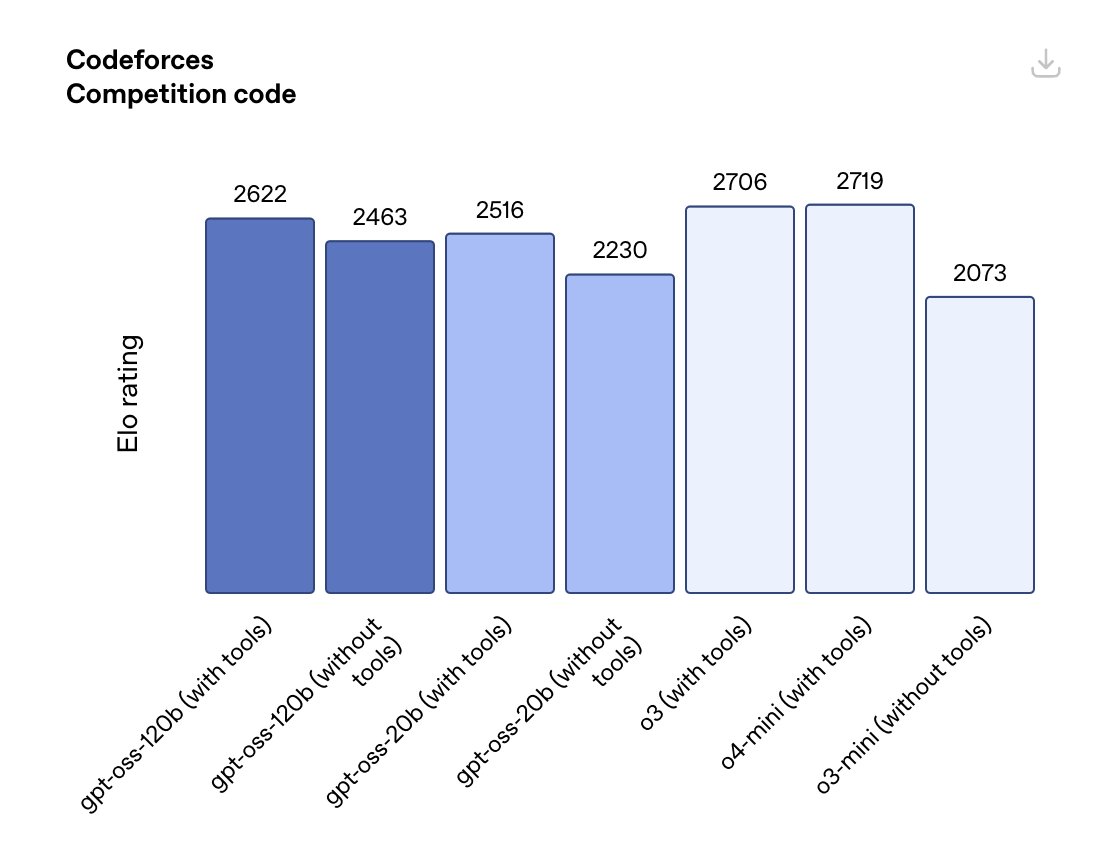

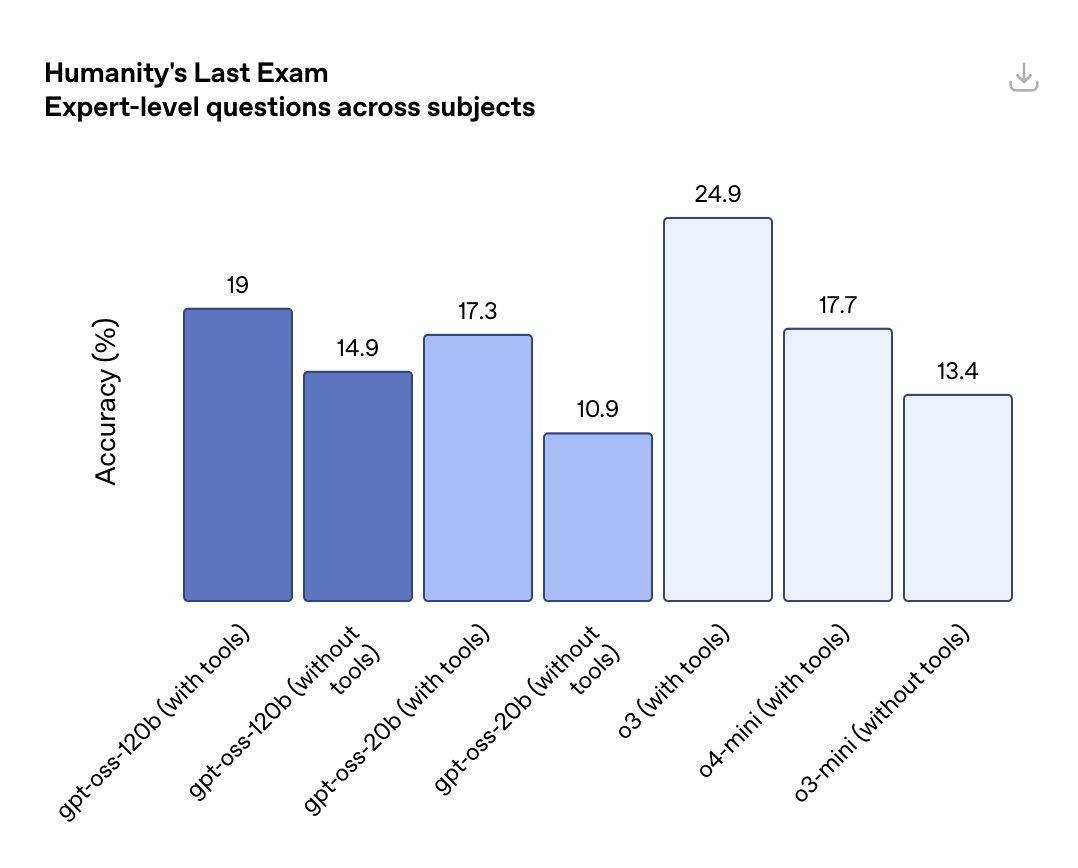

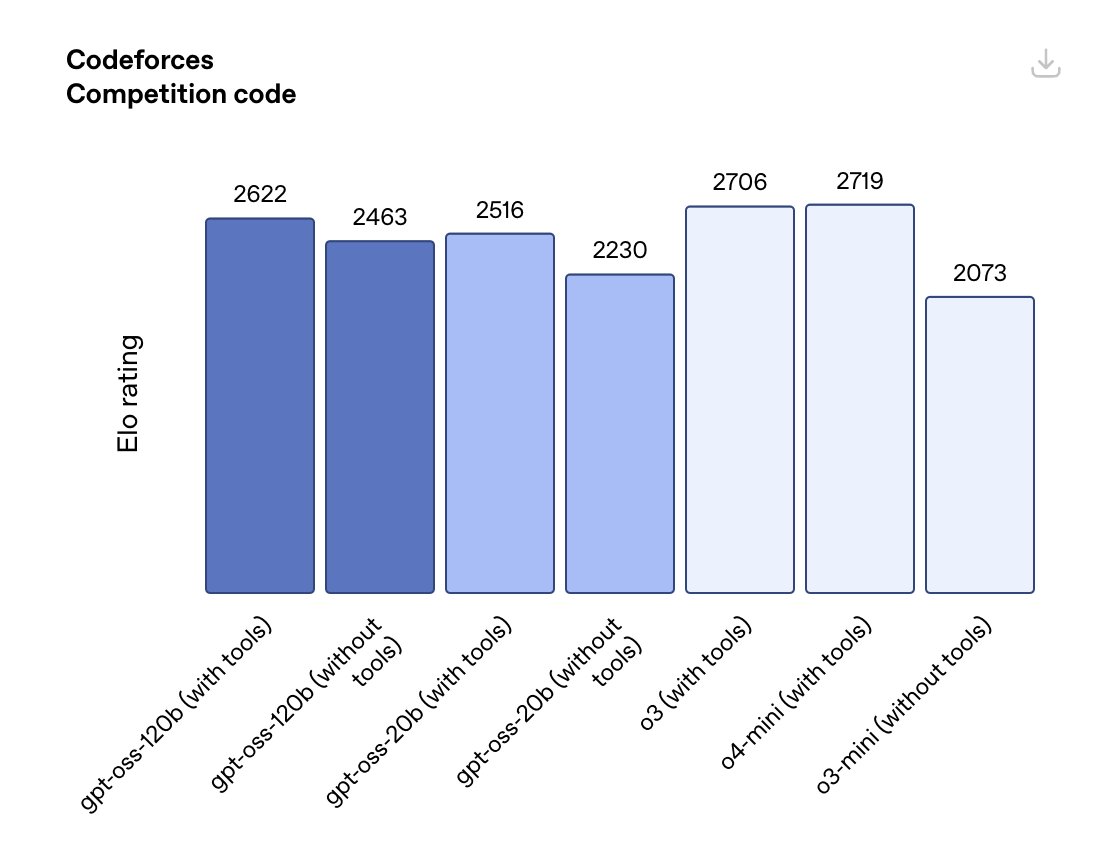

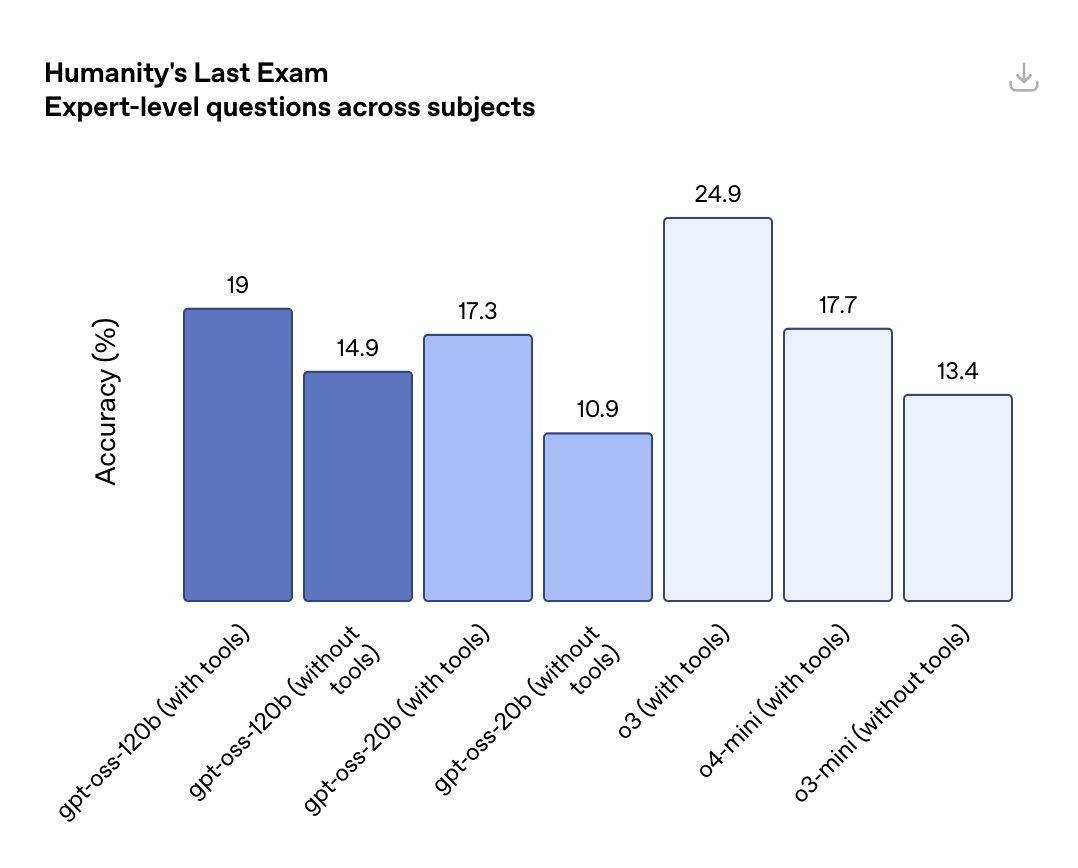

Gpt-oss-120b 大致相当于 OpenAI o4-mini,20B 的相当于 o3-mini

120B 需要 80G 显存推理,20B 只需要 16G 显存设备。

目前你知道的所有 LLM 周边生态都已经支持这两个模型,比如 ollama 这种 https://t.co/9vW2PQ2qUe

架构与技术细节

均为 Transformer 架构,采用专家混合(MoE)技术,提升推理效率。

gpt-oss-120b:36 层,1170 亿参数,每个 token 激活 51 亿参数,128 个专家,每 token 激活 4 个专家。

gpt-oss-20b:24 层,210 亿参数,每个 token 激活 36 亿参数,32 个专家,每 token 激活 4 个专家。

支持分组多查询注意力(grouped multi-query attention)、RoPE 位置编码,原生支持超长上下文。

训练数据以高质量英文纯文本为主,重点覆盖 STEM、编程和通用知识。

训练与后训练:

采用与 o4-mini 类似的后训练流程,包括监督微调和强化学习阶段。

支持三档推理强度(低、中、高),可通过系统消息灵活设置,兼顾延迟和性能。

具备强大的指令执行、工具调用(如网页搜索、Python 代码执行)和推理能力。

开源与生态:

权重已在 Hugging Face 免费开放下载,支持 MXFP4 量化格式,便于本地和多平台部署。

提供 Harmony 提示格式、Python/Rust 渲染器、PyTorch/Metal 参考实现和示例工具。

与 Hugging Face、Azure、Ollama、AWS、Cloudflare 等主流平台合作,优化多硬件支持。

Windows 设备有专门的 GPU 优化版本,支持本地推理和开发。