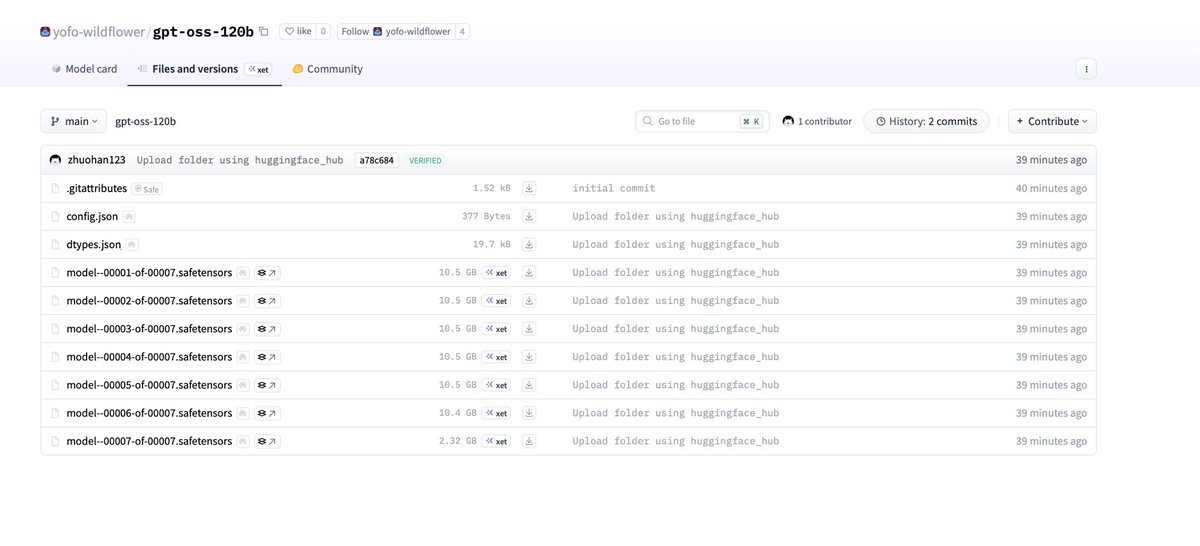

Open AI 开源模型 gpt-oss 信息泄露! 这是一个操作系统系列模型,最小参数 20B 最大参数 120B 模型的配置文件也被泄露: MoE Transformer:36 层,128 个专家,Top-4 路由 注意力:64 个注意力头、每头 64 维;GQA 总参数(稀疏总量)≈ 116B 训练/基础上下文:initial_context_length: 4096 RoPE 长上下文扩展:可将可用上下文扩至约 4096×32 ≈ 131k tokens 滑动窗注意力:sliding_window: 128 表示主要采用 局部注意力窗口 128 KV 缓存占用:每 token 每层 K+V 元素数 ≈ 72 KB/token。GQA 已显著降低占用。 总结:大规模稀疏 MoE(总参 ~116B,活跃 ~5.1B)的长上下文模型(~128k 级别,带 NTK RoPE),采用 GQA + 滑动窗注意力 以降低内存与计算;注意力投影宽于隐藏维以增加容量。适合高吞吐与长文场景,在解码侧具有较优的 KV 开销与并行特性。