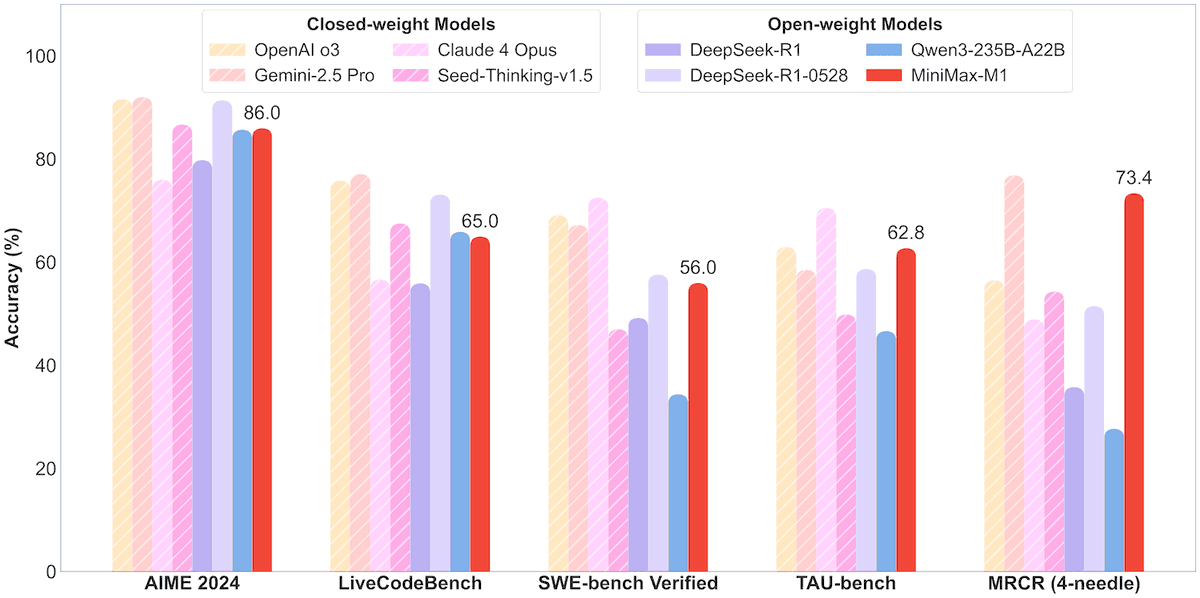

MiniMax深夜发货,放出了全球最长上下文推理模型:M1,原生支持100万token上下文,是DeepSeek R1 8倍 在复杂的软件工程、工具使用、以及长上下文任务上优于DeepSeek-R1、Qwen3-235B M1结合了MoE架构和闪电注意力机制,基于MiniMax-Text-01开发,4560亿参数,每次激活459亿 支持100万token上下文,8万token输出 基于强化学习+CISPO新算法训练 相当于MiniMax-M1同时具备超强记忆力、思考速度和学习能力,使其可以处理长文本和复杂任务 #LLM #MiniMaxM1

github:https://t.co/k5fw2RPGey https://t.co/32kOeTdfED